سرور گرافیکی (ابر رایانه هوش مصنوعی NVIDIA HGX H100 8-GPU)

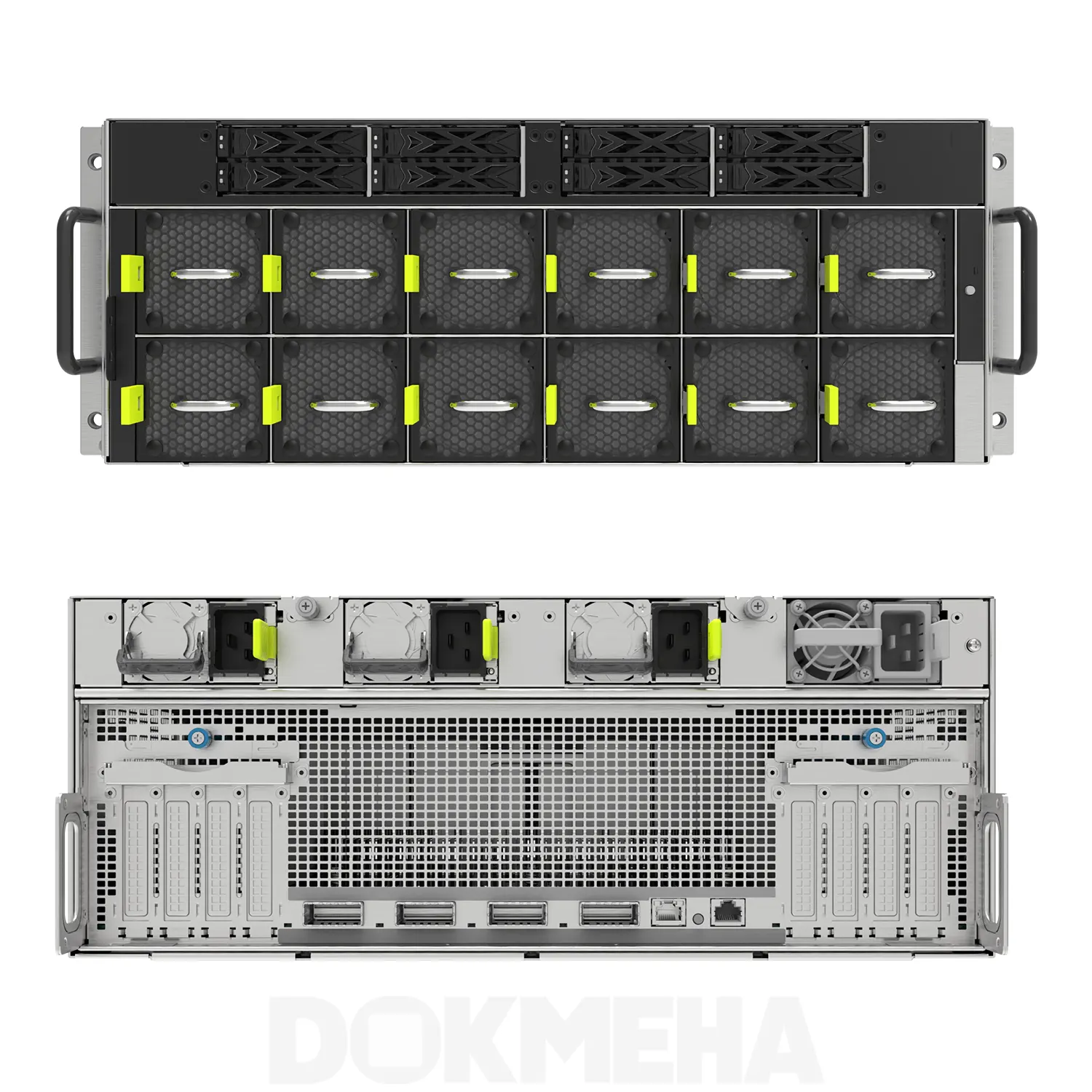

ابر رایانه یا سرور گرافیکی NVIDIA HGX H100 ، یک پلتفرم کلیدی مبتنی بر سرور GPU به شمار میرود. این پلتفرم پیشرفته با امنیت بالا، عملکردی با تاخیر کم ارائه می دهد و مجموعه کاملی از قابلیت ها را از شبکه تا محاسبات در مقیاس مرکز داده،که برای تسریع امور مرتبط با هوش مصنوعی (AI) و محاسبات با عملکرد بالا (HPC) طراحی شده است.

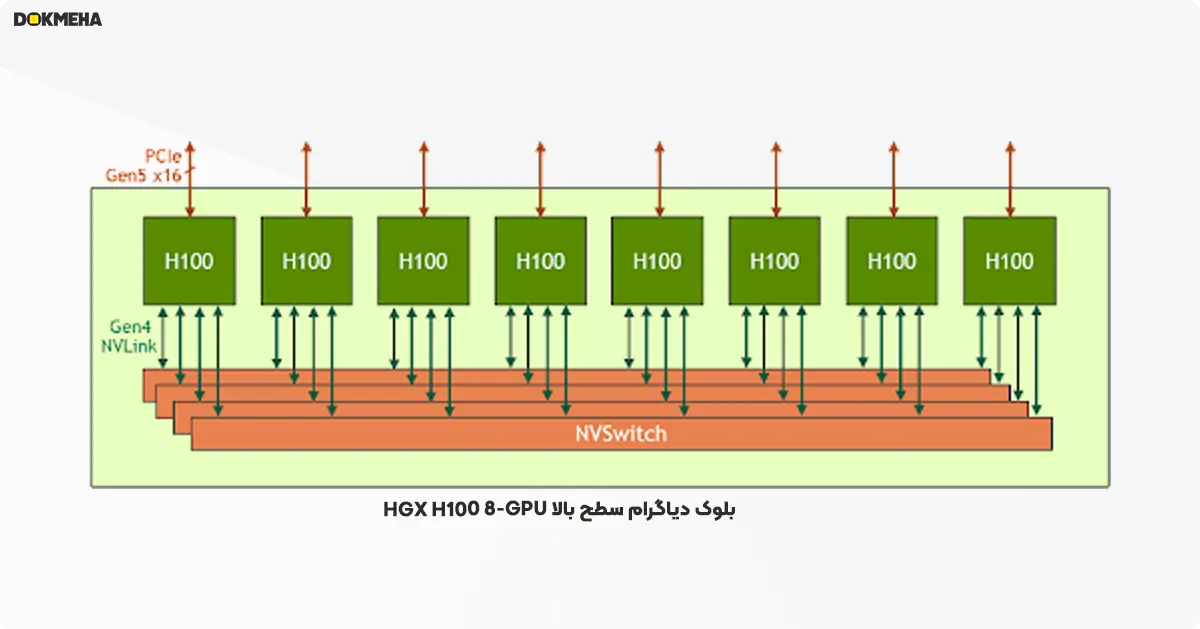

سرور گرافیکی NVIDIA HGX H100 8-GPU عنصر کلیدی نسل جدید سرورهای پردازنده گرافیکی با معماری Hopper است. این ابر رایانه میزبان هشت پردازنده گرافیکی هسته تنسور H100 و چهار سوئیچ نسل سوم NVSwitch است. هر پردازنده گرافیکی H100 دارای چندین پورت NVLink نسل چهارم بوده و به تمامی چهار سوئیچ NVSwitch متصل میشود. هر سوئیچ NVSwitch یک سوئیچ کاملاً بدون انسداد است که هر هشت پردازنده گرافیکی هسته تنسور H100 را به طور کامل به هم متصل میکند.

این توپولوژی کاملاً متصل از NVSwitch به هر H100 اجازه می دهد تا به طور همزمان با هر H100 دیگر ارتباط برقرار کند. قابل توجه است که این ارتباط با سرعت دو طرفه NVLink یعنی ۹۰۰ گیگابایت بر ثانیه (گیگابایت بر ثانیه) اجرا می شود که بیش از ۱۴ برابر پهنای باند باس فعلی PCIe Gen4 x16 است.

سوئیچ NVSwitch نسل سوم همچنین شتاب سخت افزاری جدیدی را برای عملیات جمعی با کاهش های چندپخشی و درون شبکه NVIDIA SHARP فراهم می کند. با ترکیب سرعت بالاتر NVLink، پهنای باند موثر برای عملیات جمعی هوش مصنوعی رایج مانند all-reduce، در مقایسه با HGX A100 سه برابر می شود. شتاب NVSwitch برای عملیات جمعی همچنین بار روی پردازنده گرافیکی را به طور قابل توجهی کاهش می دهد.

HGX H100 8-GPU با پشتیبانی از شبکه NVLink

مدلهای جدید محاسبات با عملکرد بالا (HPC) در اگزاسکِیل (Exascale) و هوش مصنوعی با پارامترهای تریلیونی، برای کارهایی مانند هوش مصنوعی مکالمه دقیق، حتی در ابررایانهها ماهها طول میکشند تا آموزش ببینند. فشرده کردن این زمان به اندازه سرعت کسب و کار و تکمیل آموزش در عرض چند ساعت، نیازمند ارتباط پر سرعت و یکپارچه بین تمام پردازندههای گرافیکی (GPU) در یک خوشه سرور است.

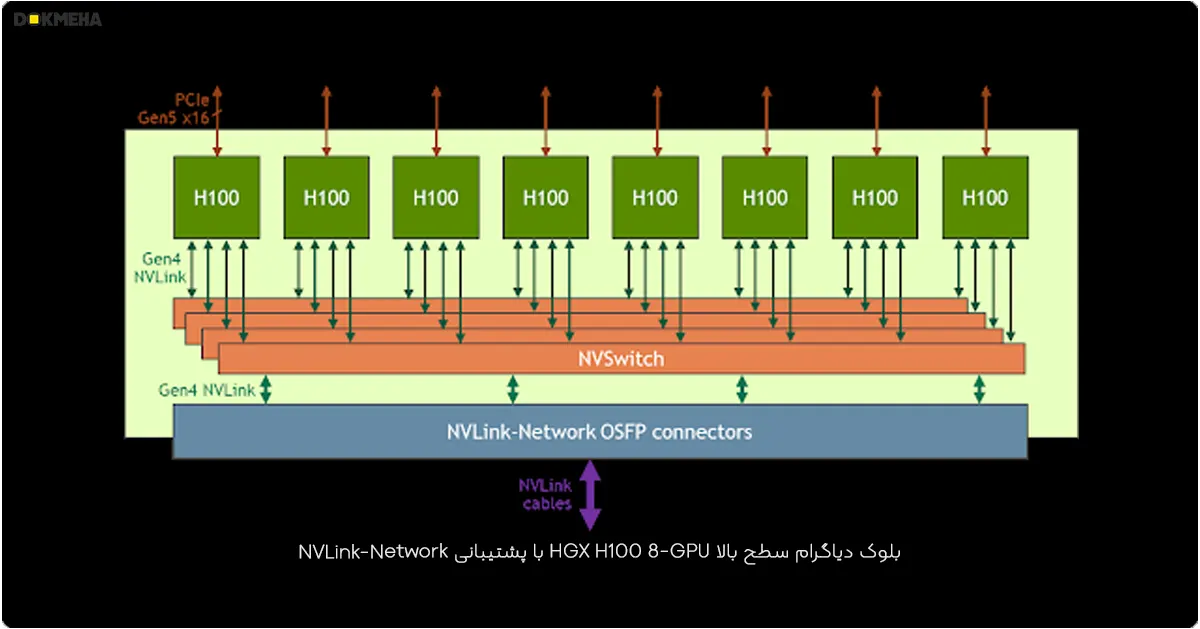

برای مقابله با این سناریوهای استفاده عظیم، رابطهای جدید NVLink و NVSwitch به گونهای طراحی شدهاند که به HGX H100 8-GPU اجازه دهند تا با شبکه NVLink جدید، از دامنه بسیار بزرگتری از NVLink پشتیبانی کرده و مقیاسبندی کند. نسخهای دیگر از HGX H100 8-GPU نیز از این پشتیبانی شبکه NVLink بهرهمند است.

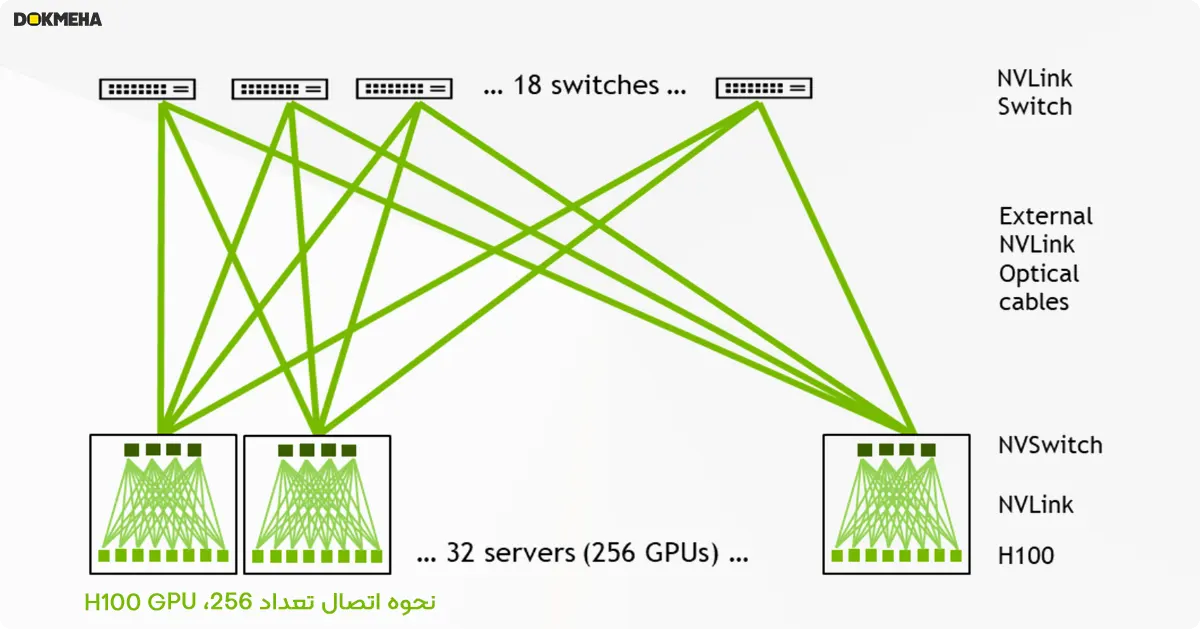

گرههای سیستم ساخته شده با HGX H100 8-GPU با پشتیبانی از شبکه NVLink، میتوانند از طریق کابلهای قابل اتصال با فرم کوچک Octal (OSFP) LinkX و سوئیچ خارجی جدید NVLink به طور کامل به سیستمهای دیگر متصل شوند. این اتصال حداکثر ۲۵۶ دامنه NVLink با پردازندههای گرافیکی (GPU) را امکانپذیر میکند.[تصویر زیر توپولوژی خوشه ای را برای این سیستم نشان میدهد.]

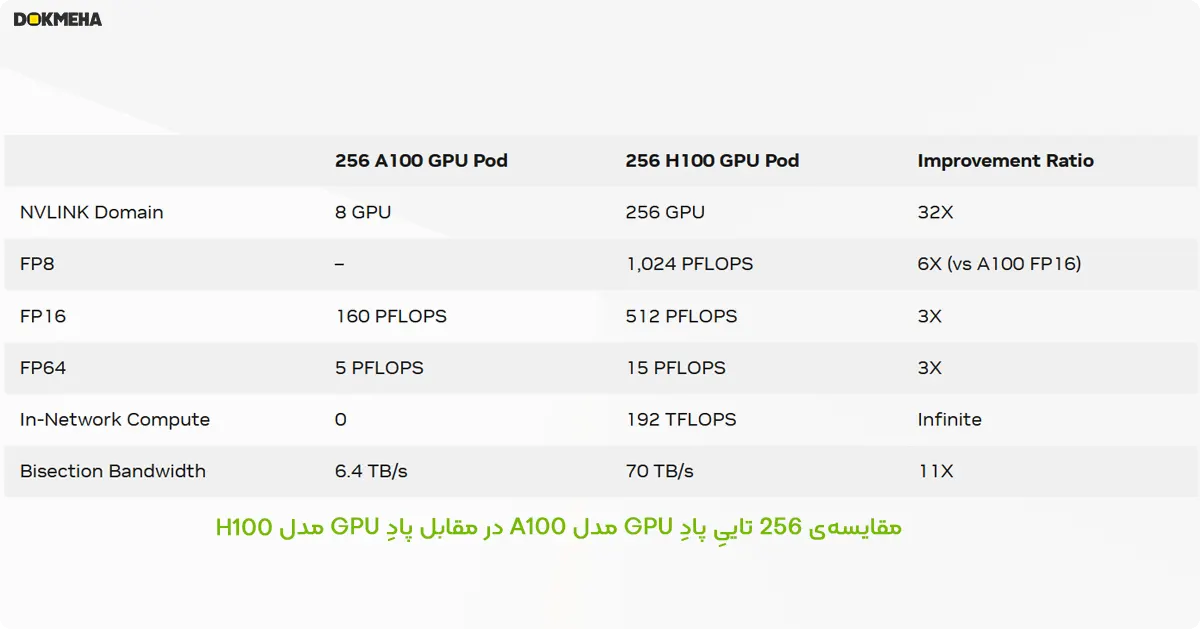

مقایسهی ۲۵۶ تاییِ پادِ GPU مدل A100 در مقابل پادِ GPU مدل H100

مقایسهی دو سیستم قدرتمند پردازش گرافیکی از شرکت انویدیا میپردازد Comparing 256 A100 GPU Pod vs 256 H100 GPU Pod.

برتریهای کلیدی H100:

-

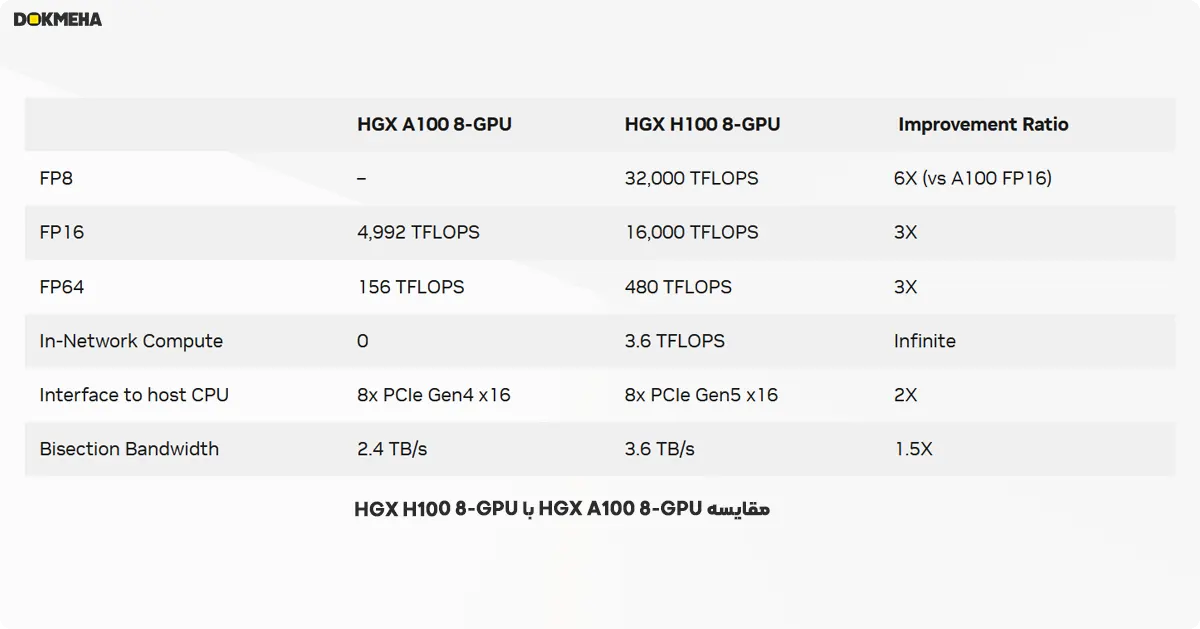

- سرعت و کارایی: معماری Hopper در H100 نسبت به A100، عملکرد را به میزان قابل توجهی بهبود بخشیده است. این بهبود در محاسبات با دقتهای مختلف (FP8، FP16 و FP64) به ترتیب ۶، ۳ و ۳ برابر است.

- پهنای باند: شبکهی داخلی NVLink در H100، ارتباط بسیار سریعتری را بین پردازندههای گرافیکی (GPU) برقرار میکند و پهنای باند را تا ۱۱ برابر افزایش میدهد. این امر موجب تبادل دادهی سریعتر و کارآمدتر بین GPUها میشود.

- حافظهی مشترک: حافظهی مشترک و کش اطلاعات سطح یک (L1) در H100 نسبت به A100، ۱.۳۳ برابر بزرگتر شده است که به پردازش سریعتر دادهها کمک میکند.

- قابلیتهای نوآورانه: H100 دارای ویژگیهای جدیدی مانند واحد شتابدهندهی حافظهی تنسور (TMA) است که انتقال دادههای حجیم بین حافظهی اصلی و حافظهی مشترک را بهینه میکند.

پادِ ۲۵۶ تاییِ H100 با برخورداری از معماری جدید، شبکهی داخلی سریعتر، حافظهی بیشتر و قابلیتهای نوآورانه، نسبت به پادِ A100، عملکرد بسیار بهتری را برای کارهای هوش مصنوعی، محاسبات با عملکرد بالا و تحلیل دادهها ارائه میدهد.

حوزههای کاربرد هدف و مزایای عملکردی

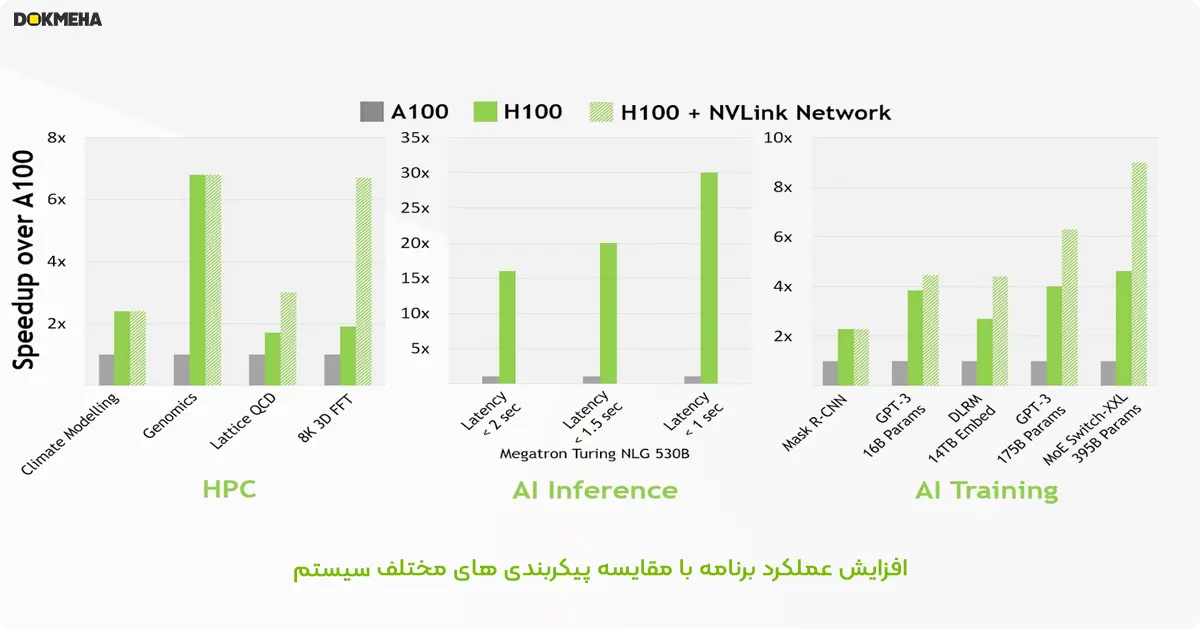

با افزایش چشمگیر قابلیتهای محاسباتی و شبکهای HGX H100، عملکرد برنامههای کاربردی هوش مصنوعی و محاسبات با عملکرد بالا (HPC) به طور قابل توجهی بهبود یافته است.

در حال حاضر، مدلهای اصلی هوش مصنوعی و HPC میتوانند به طور کامل در حافظهی کلی GPU یک گره واحد جای بگیرند. برای نمونه، مدلهای BERT-Large، Mask R-CNN و HGX H100 کارآمدترین راهحلهای آموزشی از نظر عملکرد هستند.

اما برای مدلهای بزرگتر و پیشرفتهتر هوش مصنوعی و HPC، مدل نیازمند مجموع حافظهی GPU از چندین گره برای جایگیری است. به عنوان مثال، یک مدل توصیهی یادگیری عمیق (DLRM) با جداول تعبیهشدهی ترابایتی، یک مدل پردازش زبان طبیعی با کارشناسی ترکیبیِ بزرگ (MoE)، و HGX H100 با شبکهی NVLink که گلوگاه ارتباطی کلیدی را سرعت میبخشد، بهترین راهحل برای این نوع حجم کاری به شمار میرود.

همانطور که در تصویر زیر می بینید معماری پردازنده گرافیکی NVIDIA H100 نشان داده شده است، شبکهی NVLink باعث افزایش قابل توجه عملکرد میشود.

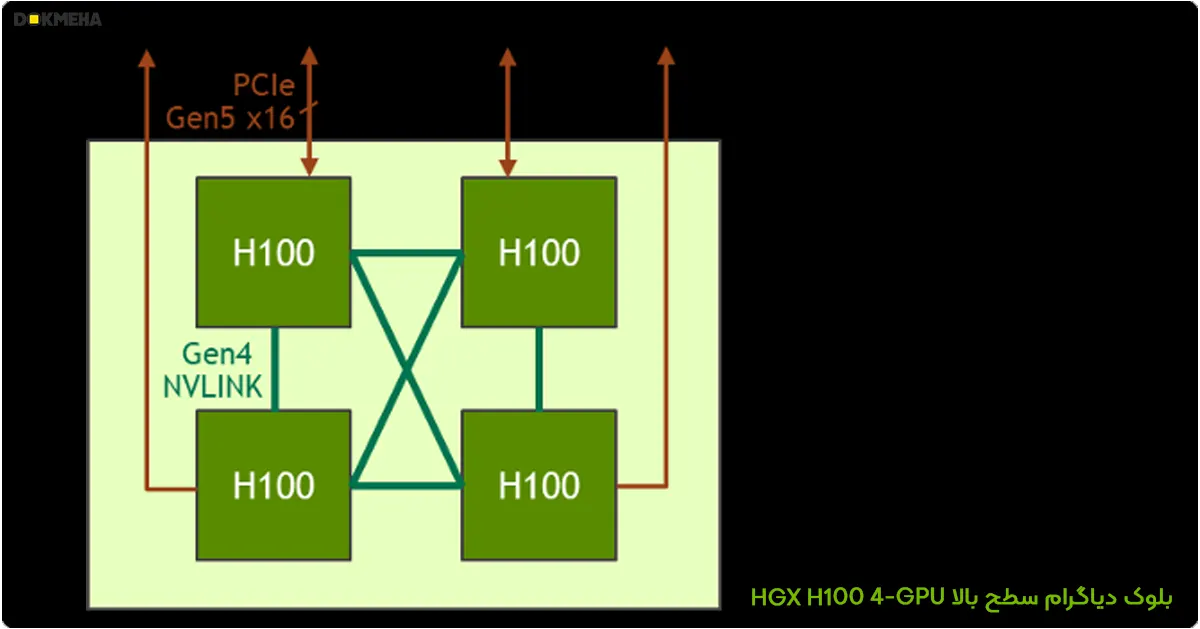

HGX H100 با ۴ پردازنده گرافیک

علاوه بر نسخهی ۸ پردازندهای، خانوادهی HGX شامل نسخهای با ۴ پردازندهی گرافیکی نیز میشود که به طور مستقیم با نسل چهارم NVLink متصل است.

این نسخه ۴ نسخهای از HGX H100، ایدهآل برای استقرارهای با تراکم بالا یا سناریوهایی است که به اندازهی قدرت کامل ۸ پردازندهی گرافیکی نیاز ندارند. با اتصال NVLink، این کارتهای گرافیکی میتوانند با یکدیگر به خوبی ارتباط برقرار کرده و کارایی را برای طیف وسیعی از وظایف هوش مصنوعی و محاسبات با عملکرد بالا (HPC) به ارمغان آورند.

پهنای باند NVLink نقطه به نقطه H100-to-H100 به میزان ۳۰۰ گیگابایت بر ثانیه دو طرفه است که تقریباً ۵ برابر سریعتر از گذرگاه PCIe Gen4 x16 امروزی است. این امر موجب تبادل بسیار سریعتر دادهها بین پردازندههای گرافیکی شده و در نهایت عملکرد کلی سیستم را افزایش میدهد.

طراحی فشرده HGX H100 4-GPU برای استقرارهای محاسبات با عملکرد بالا (HPC بهینه شده است:

نسخهی ۴ پردازندهی HGX H100 به گونهای طراحی شده که بتواند در محیطهای با فضای محدود نیز به کار گرفته شود:

- چگالی بالای پردازنده در هر رک: با استفاده از سیستم خنککنندهی مایع به ارتفاع یک واحد (۱U)، امکان جایگذاری تعداد بیشتری از کارتهای گرافیک HGX H100 با ۴ پردازنده در هر رک وجود دارد. این امر موجب افزایش چگالی پردازندههای گرافیکی در فضای موجود میشود.

- مصرف انرژی پایین: معماری بدون نیاز به سوئیچ PCIe، اتصال مستقیم پردازندههای گرافیکی HGX H100 با ۴ پردازنده به پردازندهی مرکزی را ممکن میکند. این اتصال مستقیم علاوه بر کاهش مواد اولیهی سیستم، باعث صرفهجویی در مصرف برق نیز میشود.

- انعطافپذیری برای پردازشهای با بار پردازندهی مرکزی بالا: برای پردازشهایی که نیازمند قدرت پردازش مرکزی بیشتری هستند، امکان اتصال HGX H100 با ۴ پردازنده به دو سوکت پردازندهی مرکزی وجود دارد. این اتصال موجب افزایش نسبت CPU به GPU شده و پیکربندی متعادلتری را برای سیستمهای با نیاز پردازشی ترکیبی فراهم میکند.

انویدیا HGX H100: قدرتمندترین پلتفرم ابررایانهای هوش مصنوعی با پردازش سرتاسری

ساخته شده به طور ویژه برای هوش مصنوعی، شبیهسازی و تحلیل داده

رشد چشمگیر حجم مدلها و گسترش موارد کاربرد هوش مصنوعی، شبیهسازیهای پیچیده و مجموعه دادههای عظیم، نیازمند استفاده از چندین پردازندهی گرافیکی با اتصالات فوقالعاده سریع و یک پشته نرمافزاری کاملاً شتابدهنده است. پلتفرم ابررایانهای هوش مصنوعی NVIDIA HGX، با گردهم آوردن قدرت کامل پردازندههای گرافیکی انویدیا، فناوری NVLink، شبکه و پشتهی نرمافزاری کاملاً بهینهسازیشدهی هوش مصنوعی و محاسبات با عملکرد بالا (HPC) از کاتالوگ NGC، عملکردی بینظیر را برای اجرای برنامههای کاربردی به ارمغان میآورد. انعطافپذیری و عملکرد بهینه در تمامی مراحل، این امکان را برای ارائهدهندگان خدمات، پژوهشگران و دانشمندان فراهم میکند تا راهحلهای هوش مصنوعی، شبیهسازی و تحلیل داده را با سرعتی بیسابقه برای رسیدن به بینش (دادههای تحلیلی) ارائه دهند.

کاتالوگ NGC، که در متن مربوط به NVIDIA HGX به آن اشاره شده است، مخفف NVIDIA GPU Cloud است. این کاتالوگ مجموعهای از کانتینرهای نرمافزاری است که به طور خاص برای اجرا بر روی پردازندههای گرافیکی NVIDIA طراحی و بهینهسازی شدهاند. این کانتینرها شامل نرمافزار، کتابخانهها و وابستگیهای از پیش نصبشده مورد نیاز برای کارهای مختلفی مانند یادگیری عمیق، محاسبات با عملکرد بالا (HPC)، یادگیری ماشین و علم داده هستند.

در اینجا خلاصهای از نکات کلیدی در مورد کاتالوگ NGC ارائه شده است:

- ارائه نرمافزار از پیش پیکربندی شده برای GPUها: کاتالوگ NGC نیاز به تنظیم و پیکربندی دستی محیطهای نرمافزاری برای وظایف در حال اجرا بر روی پردازندههای گرافیکی NVIDIA را از بین میبرد.

- بهبود کارایی: با استفاده از کانتینرهای از پیش ساخته و بهینهشده، کاربران میتوانند بر روی کار خود تمرکز کنند و از اتلاف وقت در تنظیم محیطهای نرمافزاری جلوگیری کنند.

- طیف گستردهای از برنامهها: این کاتالوگ کانتینرهایی را برای کارهای مختلف از جمله چارچوبهای یادگیری عمیق (TensorFlow، PyTorch)، برنامههای HPC، ابزارهای علم داده و موارد دیگر ارائه میدهد.

- دسترسی: کاتالوگ NGC به صورت آنلاین قابل دسترسی است https://catalog.ngc.nvidia.com و کاربران میتوانند بر اساس نیازهای خاص خود کانتینرها را مرور و دانلود کنند.

در زمینه NVIDIA HGX، کاتالوگ NGC سختافزار را با ارائه ابزارهای نرمافزاری لازم برای استفاده کامل از قدرت پردازش GPUهای NVIDIA برای کارهای مختلف هوش مصنوعی و HPC تکمیل میکند.

پلتفرم بینظیر محاسبات شتابدهندهی سرتاسری

سیستم NVIDIA HGX H100 با ترکیب هستههای تنسور پردازندههای گرافیکی H100 و اتصالات پرسرعت، قدرتمندترین سرورهای جهان را ارائه میدهد.

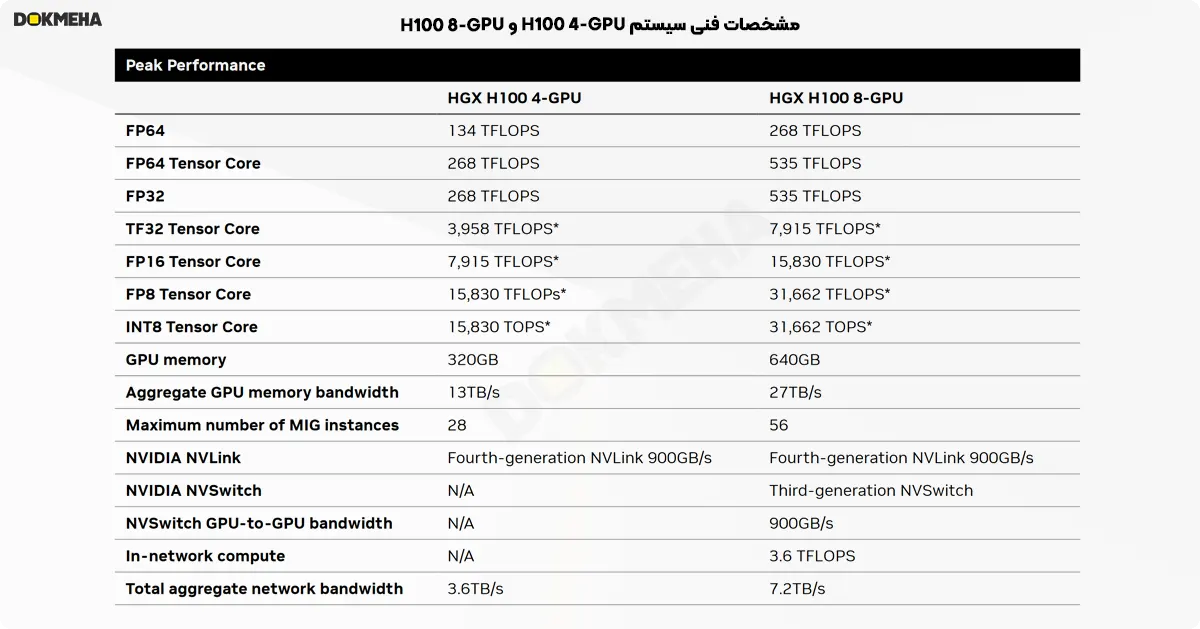

HGX H100 با امکان تجهیز به حداکثر هشت پردازندهی گرافیکی H100، از حداکثر ۶۴۰ گیگابایت حافظهی GPU و پهنای باند کلی حافظهی ۲۴ ترابایت بر ثانیه برخوردار است که شتابی بیسابقه را به ارمغان میآورد. این پلتفرم با ارائه قدرت پردازشی خیرهکنندهی ۳۲ پتا فلاپس، به عنوان قدرتمندترین پلتفرم سرور مقیاسپذیر شتابدهنده برای هوش مصنوعی و محاسبات با عملکرد بالا (HPC) در جهان شناخته میشود.

پلتفرم HGX H100 شامل گزینههای پیشرفتهی شبکه با سرعتهای حداکثر ۴۰۰ گیگابیت بر ثانیه است که از فناوریهای NVIDIA Quantum-2 InfiniBand و Spectrum-X Ethernet برای دستیابی به بالاترین عملکرد هوش مصنوعی بهره میبرد. HGX H100 همچنین شامل واحدهای پردازش داده (DPU) NVIDIA BlueField-3 برای فعال کردن شبکه ابری، ذخیرهسازی ترکیبی، امنیت بدون اعتماد و انعطافپذیری محاسباتی GPU در ابرهای هوش مصنوعی با مقیاسپذیری بالا (Hyperscale) است.

نکات کلیدی:

-

- ترکیبی از پردازندههای گرافیکی قدرتمند H100 با اتصالات پرسرعت

- حداکثر ۶۴۰ گیگابایت حافظهی GPU و پهنای باند کلی حافظهی ۲۴ ترابایت بر ثانیه

- قدرت پردازشی ۳۲ پتا فلاپس برای عملکرد بینظیر در هوش مصنوعی و HPC

- گزینههای شبکهی پرسرعت با فناوریهای NVIDIA Quantum-2 InfiniBand و Spectrum-X Ethernet

- واحدهای پردازش داده (DPU) NVIDIA BlueField-3 برای شبکه ابری، ذخیرهسازی ترکیبی، امنیت و انعطافپذیری

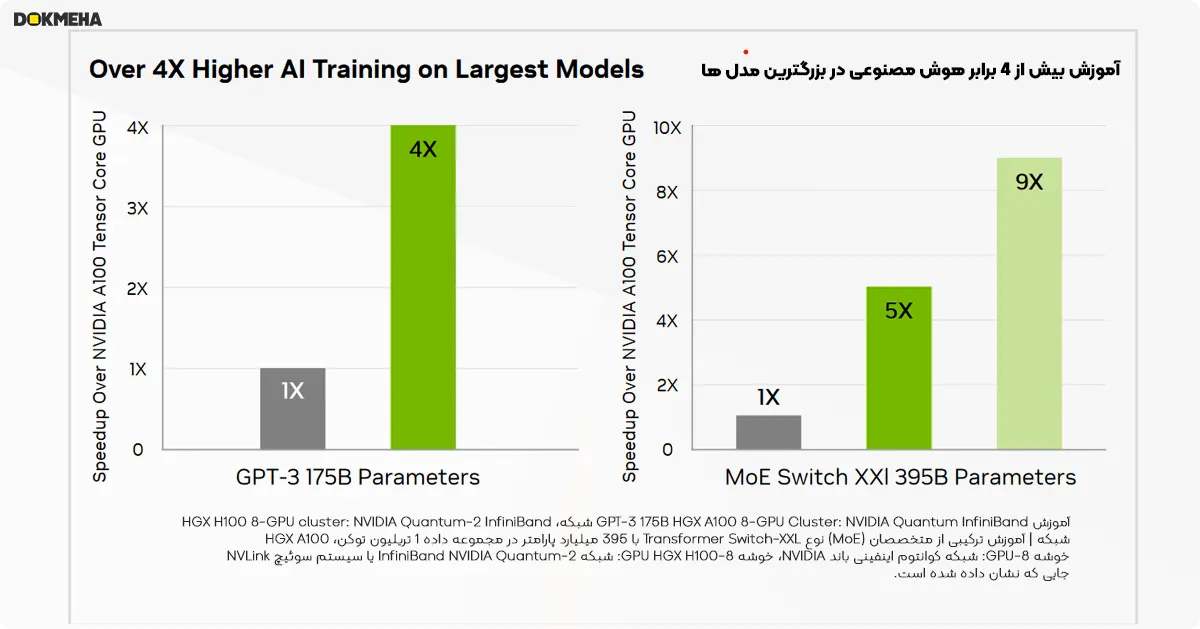

آموزش یادگیری عمیق: عملکرد و مقیاسپذیری

پردازندههای گرافیکی NVIDIA H100 که در سیستمهای HGX H100 به کار میروند، از موتور ترانسفورماتور با دقت FP8 بهره میبرند. این قابلیت موجب میشود تا آموزش مدلهای زبان بزرگ مانند GPT-3 175B، تا ۴ برابر سریعتر از نسل قبل انجام گیرد.

ترکیبی از نسل چهارم NVLink که پهنای باند ۹۰۰ گیگابیت بر ثانیه را برای اتصال GPU به GPU فراهم میکند، سیستم سوئیچ NVLink که ارتباطات گروهی را بین تمام پردازندههای گرافیکی در سراسر گرهها تسریع میبخشد، رابط PCIe Gen5 و نرمافزار NVIDIA Magnum IO مقیاسپذیری کارآمدی را ارائه میدهد، از شرکتهای کوچک تا خوشههای عظیم و یکپارچهی پردازندههای گرافیکی.

این پیشرفتهای زیرساختی، در کنار مجموعهی نرمافزاری NVIDIA AI Enterprise، پلتفرم دادهی HGX H100 را به قدرتمندترین پلتفرم هوش مصنوعی و محاسبات با عملکرد بالا (HPC) در دیتاسنتر تبدیل میکند.

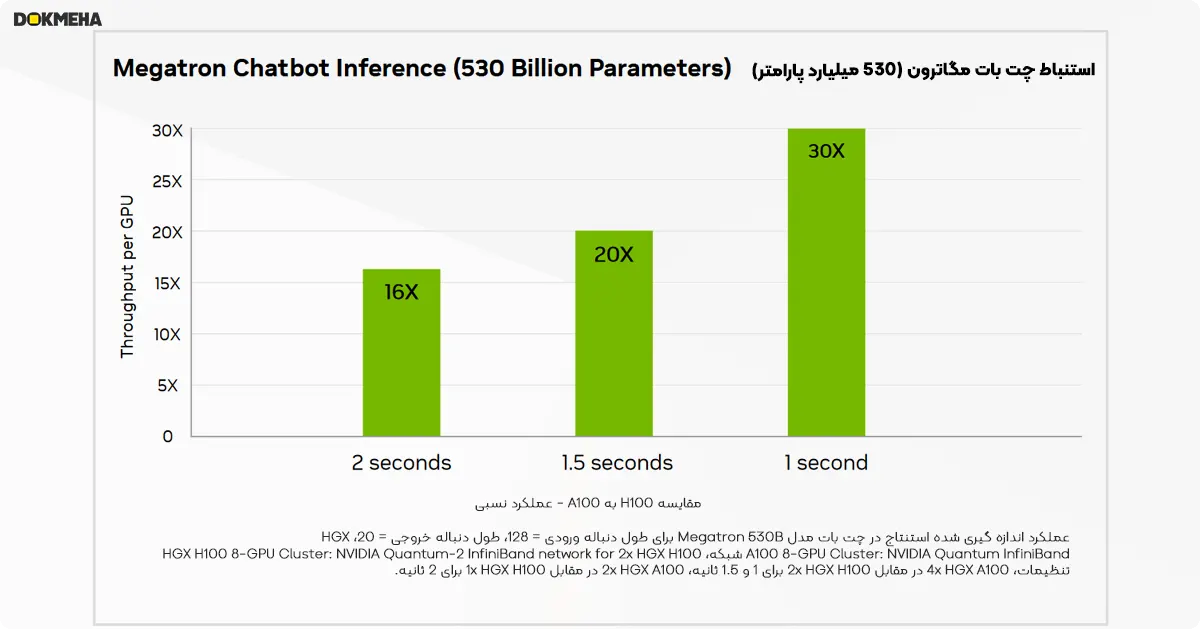

استنتاج یادگیری عمیق: عملکرد و تطبیقپذیری

سیستم HGX H100 با پیشرفتهای متعدد، رهبری انویدیا در حوزهی استنتاج یادگیری عمیق را بیش از پیش تثبیت کرده است. این پیشرفتها موجب تسریع استنتاج تا ۳۰ برابر نسبت به نسل قبل در چتباتهای مبتنی بر مدل Megatron با ۵۳۰ میلیارد پارامتر شدهاند.

- هستههای تنسور نسل چهارم: این هستهها همهی انواع دقت (دقت دودویی) را تسریع میکنند که شامل FP64، TF32، FP32، FP16 و INT8 میشود.

- موتور ترانسفورماتور: این موتور با استفادهی ترکیبی از FP8 و FP16، میزان مصرف حافظه را کاهش میدهد و ضمن حفظ دقت، عملکرد را برای مدلهای زبان بزرگ افزایش میدهد.

به طور خلاصه، HGX H100 با بهرهگیری از نسل جدید هستههای تنسور و موتور ترانسفورماتور، قادر است طیف وسیعی از انواع دقت را با سرعت بالا پردازش کند و برای استنتاج در مدلهای یادگیری عمیق پیچیده، عملکرد فوقالعادهای ارائه دهد.

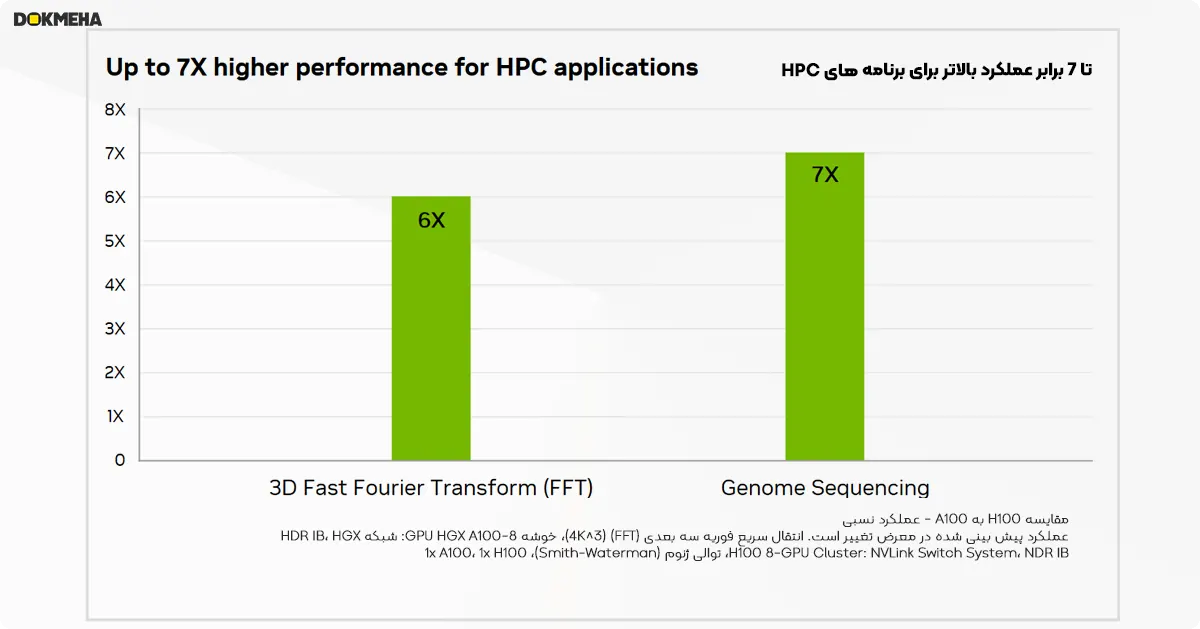

محاسبات با عملکرد بالا (HPC) در HGX H100: هستههای تنسور سریعتر با دقت دودویی بالا و برنامهنویسی پویا

سیستم HGX H100 با سه برابر کردن تعداد عملیات ممیز شناور بر ثانیه (FLOPS) در هستههای تنسور با دقت دودویی (double-precision)، حداکثر ۵۳۵ ترافلاپس قدرت پردازش FP64 را برای محاسبات با عملکرد بالا (HPC) در پیکربندی هشت پردازندهای و یا ۲۶۸ ترافلاپس در پیکربندی چهار پردازندهای ارائه میدهد.

علاوه بر این، برنامههای HPC که هوش مصنوعی را با محاسبات سنتی ترکیب میکنند، میتوانند از دقت TF32 در HGX H100 برای دستیابی به تقریباً ۸۰۰۰ ترافلاپس توان عملیاتی برای ضرب ماتریس با دقت تکبُعدی و بدون نیاز به هرگونه تغییر در کد استفاده کنند.

سیستم HGX H100 دارای دستورالعملهای جدید DPX است که الگوریتمهای برنامهنویسی پویا را تا ۷ برابر سریعتر از معماری NVIDIA Ampere اجرا میکند. بهعنوان مثال، این الگوریتمها در مقایسهی توالیهای DNA (Smith-Waterman) و تعیین ساختار پروتئین (تراز پروتئین) کاربرد دارند.

با افزایش توان عملیاتی در توابع تشخیصی مانند تعیین توالی ژن، HGX H100 این امکان را برای تمامی کلینیکها فراهم میکند تا تشخیص دقیق و لحظهای بیماری و تجویز داروهای پزشکی دقیق را ارائه دهند و بدین ترتیب، انقلابی در حوزهی مراقبتهای بهداشتی ایجاد کند.

شتابدهی به HGX با شبکهسازی انویدیا

مرکز داده، واحد جدید محاسبات به شمار میرود و شبکهسازی نقشی حیاتی در ارتقای عملکرد برنامهها در سراسر آن ایفا میکند. HGX با همکاریِ فناوری NVIDIA Quantum InfiniBand، عملکرد و کارایی بینظیری را در سطح جهانی ارائه میدهد که تضمینکنندهی حداکثر بهرهبرداری از منابع محاسباتی است.

برای مراکز داده ابری هوش مصنوعی که از اترنت استفاده میکنند، HGX به بهترین وجه با پلتفرم شبکهای NVIDIA Spectrum-X ، به کار میرود که با قدرت بخشیدن به بالاترین عملکرد هوش مصنوعی بر بستر اترنت شناخته میشود. این پلتفرم شامل سوئیچهای NVIDIA Spectrum-X و واحدهای پردازش داده (DPU) BlueField-3 است تا از طریق استفاده بهینهی منابع و تفکیک عملکرد، نتایج سازگار و قابل پیشبینیای را برای هزاران کار هوش مصنوعی همزمان در هر مقیاسی ارائه دهد. Spectrum-X همچنین امکان چندتأسیسی ابری پیشرفته و امنیت بدون اعتماد را فراهم میکند. بهعنوان یک الگوی مرجع، انویدیا ابررایانه هوش مصنوعی تولیدکنندهی مقیاسپذیرِ Israel-1 را طراحی کرده است که با سرورهای Dell PowerEdge XE9680 مبتنی بر پلتفرم هشت پردازندهی گرافیکی NVIDIA HGX، واحدهای پردازش داده BlueField-3 و سوئیچهای Spectrum-X ساخته شده است.

برای دستیابی به بالاترین کارایی ممکن در پلتفرم HGX، انویدیا گزینههای متنوعی را برای شبکهسازی ارائه میدهد. در این اینجا، به معرفی این گزینهها پرداخته شده است:

۱. پلتفرم NVIDIA Quantum-2 InfiniBand:

- سوئیچ Quantum-2: این سوئیچ، هستهی اصلی شبکهی InfiniBand با کارایی بالا به شمار میرود و وظیفهی برقراری ارتباط پرسرعت و قابل اطمینان بین سیستمهای HGX را بر عهده دارد.

- آداپتور ConnectX-7: این آداپتور، رابط ارتباطی بین سرورهای HGX و شبکهی InfiniBand است.

- واحد پردازش داده BlueField-3 (DPU): این واحد، وظایف شبکهای را به صورت سختافزاری بر عهده میگیرد و موجب کاهش بار پردازشی روی CPU و در نهایت افزایش کارایی کلی سیستم میشود.

۲ پلتفرم NVIDIA Spectrum-X:

- سوئیچ Spectrum-4: این سوئیچ، برای شبکههای اترنت با کارایی بالا طراحی شده است و امکان اتصال پرسرعت و با تأخیر کم را برای سیستمهای HGX فراهم میکند.

- ** کارت سوئیچ شبکه BlueField-3 SuperNIC:** این کارت ترکیبی، وظایف سوئیچ شبکه و واحد پردازش داده (DPU) را به صورت یکپارچه انجام میدهد و برای محیطهای با فضای محدود مناسب است.

۳ پلتفرم NVIDIA Spectrum Ethernet:

- سوئیچ Spectrum: این سوئیچ، برای شبکههای اترنت با کارایی متوسط طراحی شده است و راهحلی به صرفه برای اتصال سیستمهای HGX به شمار میرود.

- آداپتور ConnectX: این آداپتور، رابط ارتباطی بین سرورهای HGX و شبکهی اترنت است.

- واحد پردازش داده BlueField DPU (نسخهی قبلی): این واحد، وظایف شبکهای را به صورت سختافزاری بر عهده میگیرد و شبیه به BlueField-3 عمل میکند.

به طور خلاصه:

انتخاب نوع شبکهسازی به نیازمندیهای خاص شما بستگی دارد. برای دستیابی به بالاترین کارایی، پلتفرم NVIDIA Quantum-2 InfiniBand پیشنهاد میشود. در صورت نیاز به راهحلی به صرفه، پلتفرم NVIDIA Spectrum Ethernet مناسب است. پلتفرم NVIDIA Spectrum-X گزینهی میانی به شمار میرود و ترکیبی از کارایی بالا و صرفهی اقتصادی را ارائه میدهد.

اطلاعات PDF پردازنده گرافیکی NVIDIA HGX H100

هنوز دیدگاه یا پرسشی ثبت نشده است.